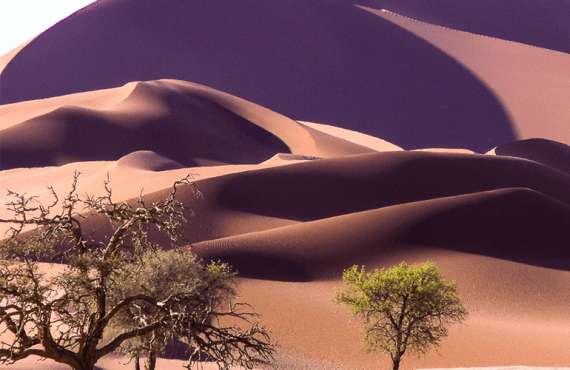

¿Cuál es la mejor época para viajar a Namibia, Botswana y Zimbabwe?

Namibia, Botswana y Zimbabwe son tres países del África austral seguros, con buenas infraestructuras turísticas y algunos de los mejores parques nacionales para hacer safaris de... Leer más